Tabby 是一个开源的自托管 AI 编码助手。使用 Tabby,每个团队都可以轻松设置自己的 LLM 驱动的代码完成服务器。独立式,无需 DBMS 或云服务。OpenAPI 接口,易于与现有基础设施(例如 Cloud IDE)集成。支持消费级 GPU。

主要功能:

-

开放:Tabby 是免费的、开源的,并且与主要的编码 LLM(CodeLlama、StarCoder、CodeGen)兼容。事实上,您可以使用和组合您喜欢的模型,而无需自己实现任何内容。

-

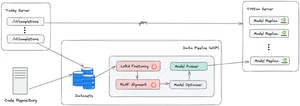

端到端:虽然大多数编码工具仅将代码完成视为编码 LLM 之上的薄包装器,但在实际场景中,IDE 扩展中的优化可能与编码 LLM 的功能一样重要。 Tabby 优化了整个堆栈:

- IDE 扩展:Tabby 通过自适应缓存策略实现准确的流式处理和取消,以确保快速完成(不到一秒)。

- 模型服务:Tabby 将相关代码解析为 Tree Sitter 标签,以提供有效的提示。

-

用户和开发人员体验:可持续的开源解决方案的关键是让每个人都能更轻松地为项目做出贡献。 AI 专家应该能够轻松理解和改进建议质量。 EngOps 团队应该发现它易于设置并感觉可以控制数据。 开发人员在编码时应该有一个 “顿悟 ”的时刻。 Tabby 优化了这些核心用户的体验,以提高团队的工作效率。

快速开始:

Windows平台:

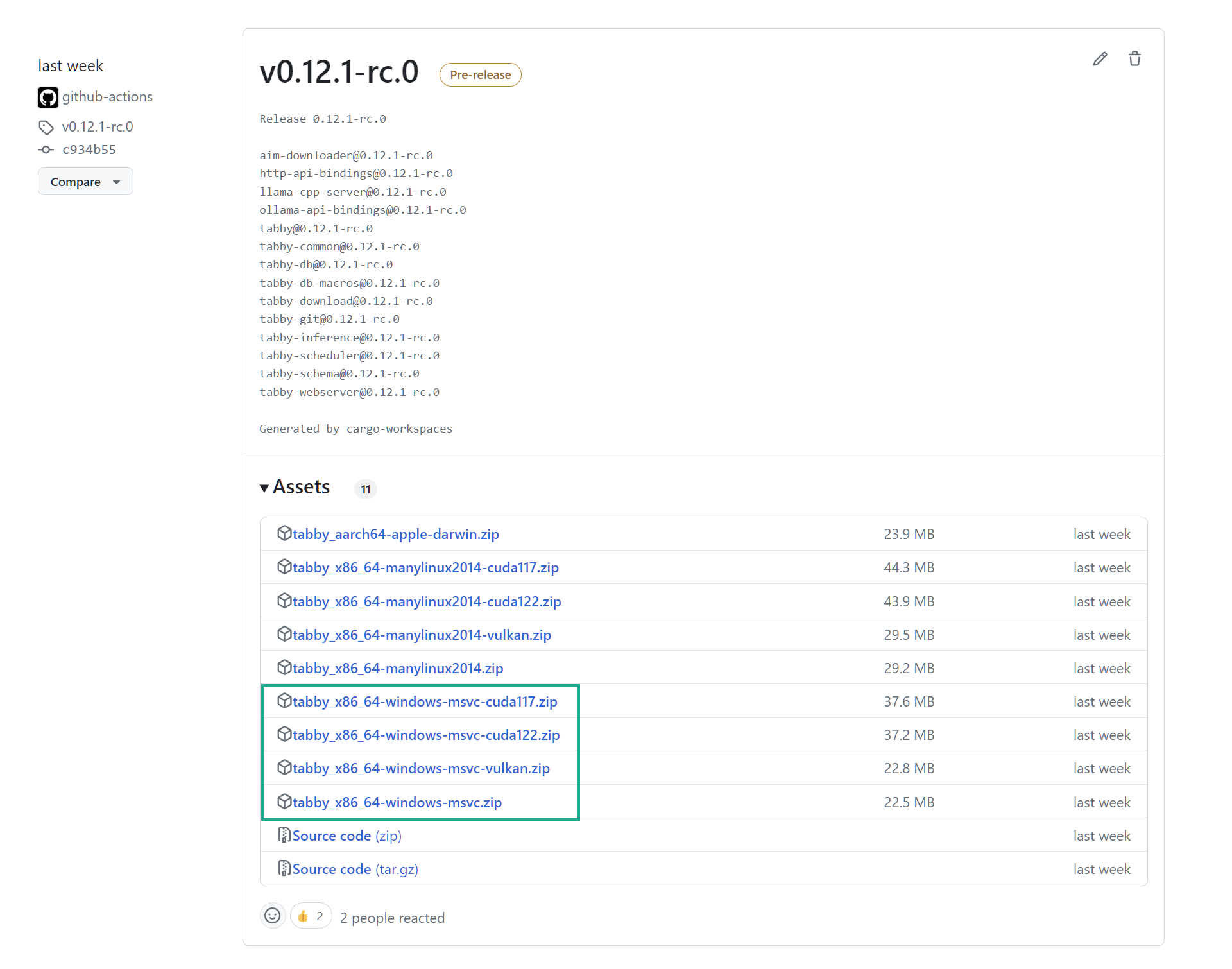

查找 Windows 版本

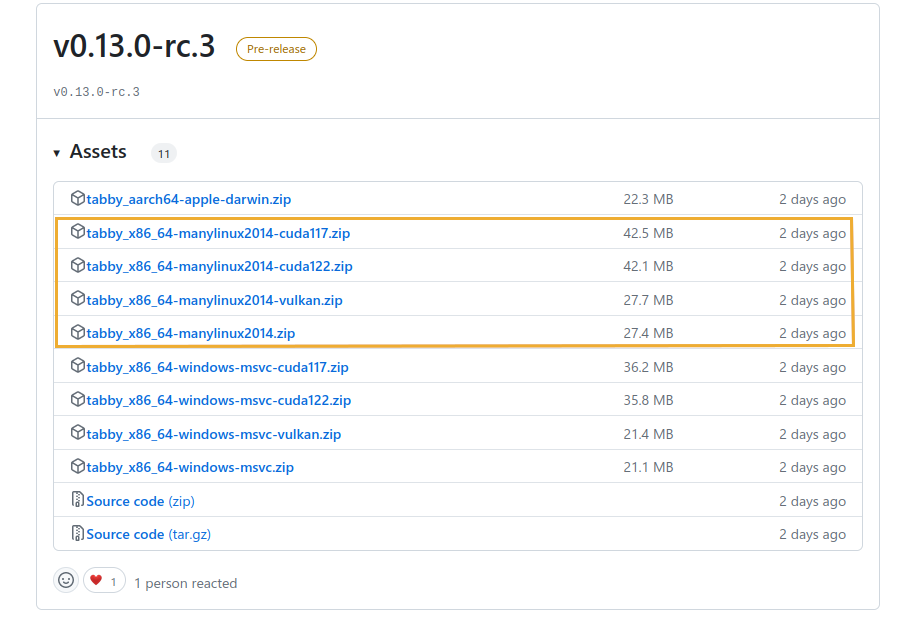

- 进入 Tabby 发布页面:https://github.com/TabbyML/tabby/releases

- 单击特定版本的 Assets 下拉列表以查找 Windows zip 文件。

下载版本

- 如果您使用的是纯 CPU 系统,请下载 tabby_x86_64-windows-msvc.zip。

- 如果您使用的是支持 GPU 的系统,请下载tabby_x86_64-windows-msvc-cuda117.zip,在此示例中,我们假设您使用的是 CUDA 11.7。

技巧:

- 从 Nvidia 下载 CUDA 工具包:https://developer.nvidia.com/cuda-toolkit

- 确保您已安装 CUDA 版本 11 或更高版本。

- 通过在命令提示符或 PowerShell 窗口中运行以下命令来检查本地 CUDA 版本:

nvcc --version

查找 Windows 可执行文件

- 解压缩文件 。

tabby_x86_64-windows-msvc-cuda117.zip - 导航到名为 的解压缩文件夹。

tabby_x86_64-windows-msvc-cuda117 - 在此文件夹中,转到 -> 。

disttabby_x86_64-windows-msvc-cuda117 - 在此目录中,您将找到一个名为 .

tabby.exe

运行 Tabby

在上一步) 所在的目录中打开命令提示符或 PowerShell 窗口(来自上一步)。tabby.exe

运行以下命令:

# For CPU-only environments

.\tabby.exe serve --model StarCoder-1B --chat-model Qwen2-1.5B-Instruct

# For CUDA-enabled environments

.\tabby.exe serve --model StarCoder-1B --chat-model Qwen2-1.5B-Instruct --device cuda

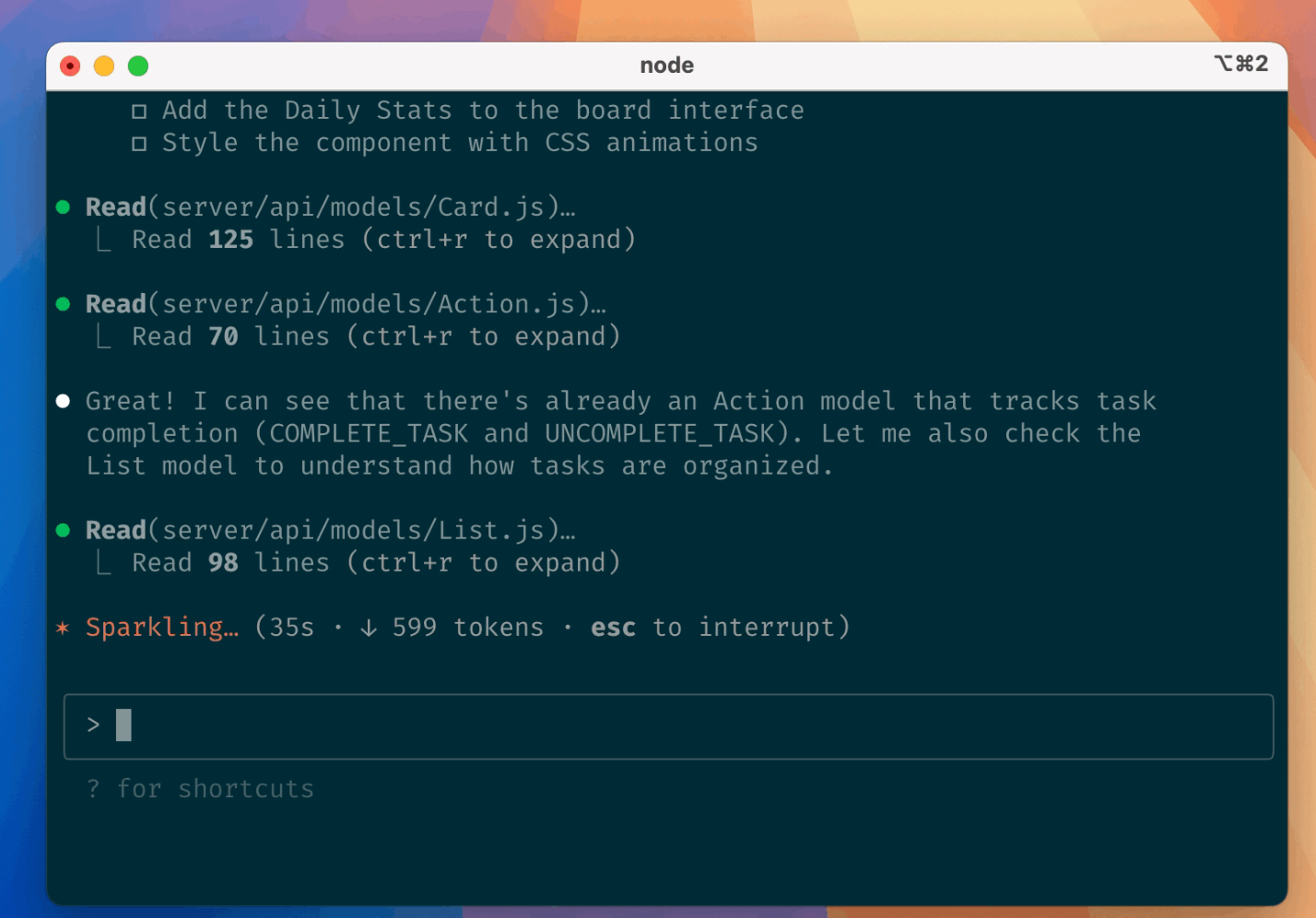

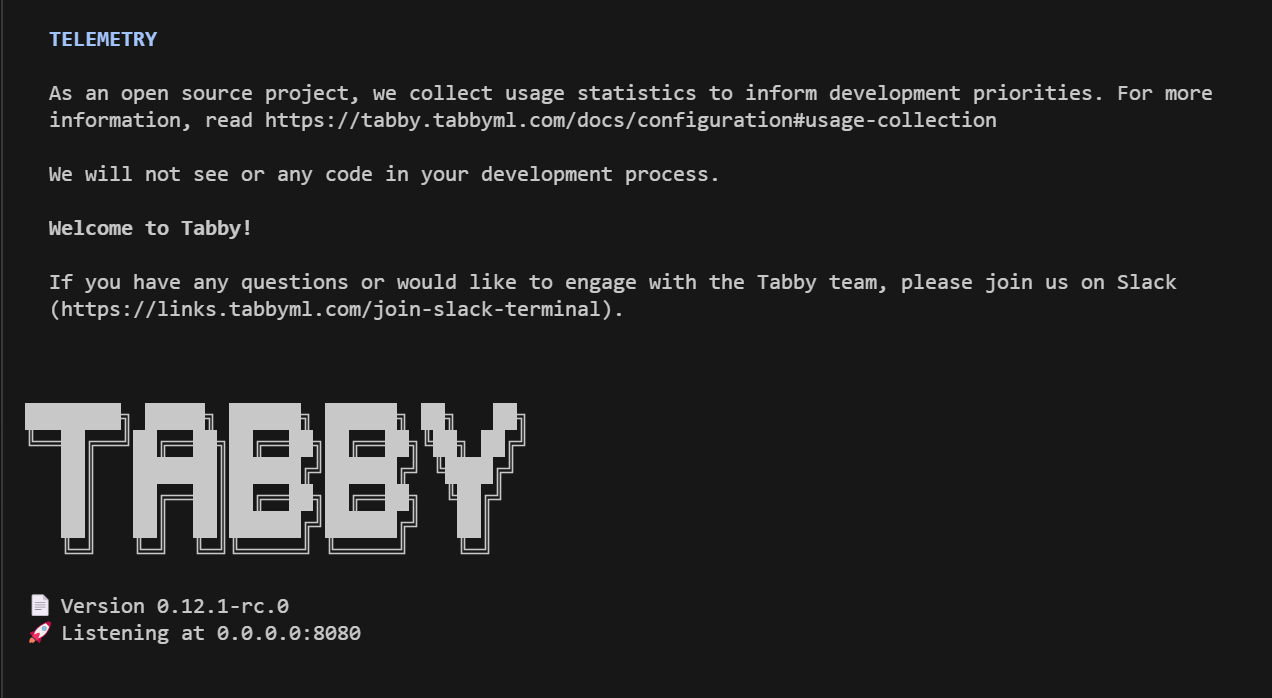

您应该会看到一条成功消息,类似于下面屏幕截图中的消息。之后,您可以访问 http://localhost:8080 来访问您的 Tabby 实例。

Linux平台:

查找 Linux 版本

- 进入 Tabby 发布页面:https://github.com/TabbyML/tabby/releases

- 单击特定版本的 Assets 下拉菜单以查找 manylinux zip 文件。

下载版本

- 如果您使用的是纯 CPU 系统,请下载 tabby_x86_64-manylinux2014.zip。

- 如果您使用的是支持 GPU 的系统,请下载tabby_x86_64-manylinux2014-cuda117.zip,在此示例中,我们假设您使用的是 CUDA 11.7。

- 如果要使用非 nvidia GPU,请下载 tabby_x86_64-manylinux2014-vulkan.zip。有关更多信息,请参阅 https://tabby.tabbyml.com/blog/2024/05/01/vulkan-support/。

技巧:

-

对于 CUDA 版本,您需要为发行版安装 nvidia-cuda-toolkit。

- 在 ubuntu 中,这将是 .

sudo apt install nvidia-cuda-toolkit - CUDA 工具包可直接从 Nvidia 获得:https://developer.nvidia.com/cuda-toolkit

- 确保您已安装 CUDA 版本 11 或更高版本。

- 通过在终端中运行以下命令来检查您的本地 CUDA 版本:

nvcc --version

- 在 ubuntu 中,这将是 .

-

对于 Vulkan 版本,您需要 Vulkan 库。在 ubuntu 中,这将是 .

sudo apt install libvulkan1

查找 Linux 可执行文件

- 解压缩您下载的文件。可执行文件将位于 dist 的子目录中。

tabby - 更改为此子目录或重新定位到您选择的文件夹。

tabby - 使其可执行:

chmod +x tabby llama-server

运行以下命令:

# For CPU-only environments

./tabby serve --model StarCoder-1B --chat-model Qwen2-1.5B-Instruct

# For GPU-enabled environments (where DEVICE is cuda or vulkan)

./tabby serve --model StarCoder-1B --chat-model Qwen2-1.5B-Instruct --device $DEVICE

您可以选择不同的模型,如模型注册表中所示

您应该会看到一条成功消息,类似于下面屏幕截图中的消息。之后,您可以访问 http://localhost:8080 来访问您的 Tabby 实例。